Редакция JMS University поговорила с руководителем отдела аналитики о необходимых для интернет-аналитика навыках и инструментах.

О собеседнике: Алексей Селезнёв — руководитель отдела аналитики и постоянный автор корпоративного блога агентства интернет-маркетинга Netpeak, автор пакетов на языке R для интернет-аналитики.

Здравствуйте, Алексей. Вы руководите отделом аналитики, а кто вообще такие аналитики? Вряд ли вы набираете людей по фразе «аналитический склад ума» в резюме.

Здравствуйте, аналитический склад ума говорит о том, что человек умеет размышлять логично и последовательно, это безусловно неотъемлемое, но не единственное обязательное качество для аналитика.

Пожалуй, самое важное в нашей отрасли — это интерес, аналитика на сегодняшний день является, пожалуй, наиболее динамично развивающимся направлением науки. Знания инструментов и методов анализа данных очень быстро теряют актуальность. Поэтому если вы выбираете профессию аналитика, то должны быть готовым к тому, что процесс обучения будет непрерывен. Я считаю, важно, чтобы работа с данными была больше хобби, чем работой. В противном случае будет сложно.

Опыт и образование по большому счёту не важны, программа вузов безнадёжно отстала от отрасли. Большую часть знаний придётся добывать самостоятельно, но благодаря интернету и большому количеству энтузиастов найти источники необходимых знаний можно быстро и, как ни удивительно, совершенно бесплатно на таких площадках, как Stepik, Computer Science Center и Coursera.

Во многих компаниях под интернет-аналитику выделяют отдельную позицию или подразделение, зачем нужны люди, занимающиеся только анализом?

В Netpeak основной задачей отдела аналитики является не столько анализ данных, сколько помощь в принятии управленческих решений всем подразделениям холдинга.

Каждый сотрудник компании принимает управленческие решения на своём уровне ответственности:

- специалист по контекстной рекламе управляет рекламными кампаниями;

- руководитель отдела принимает управленческие решения, касающиеся сотрудников своего отдела, и следит за эффективностью каждого сотрудника, при этом вряд ли он будет анализировать рекламные кампании;

- собственник бизнеса занимается стратегическими задачами на уровне всей компании и вряд ли будет заниматься анализом эффективности отдельно взятого сотрудника.

В таких условиях задачей отдела аналитики в Netpeak является предоставление сотрудникам качественных данных, необходимых для выполнения своих задач. Довольно подробно о том, чем занимается мой отдел в компании, с несколькими примерами задач, которые мы решали, я рассказывал на конференции eCommerce:

Интернет-аналитика представляется поэтапным процессом, она включает в себя сбор данных, подготовку данных, непосредственно сам анализ, автоматизацию процессов и визуализацию. Как в своей работе расставляете между ними приоритеты?

Как я уже говорил выше, моей задачей является обеспечить нужными данными сотрудников холдинга и максимально сократить рутину, поэтому приоритетом является автоматизация процесса сбора данных, и проверка качества данных.

Визуализация, как правило, строится один раз и в дальнейшем лишь дополняется, что не требует уже значительных ресурсов.

Непосредственно анализом данных в основном у нас занимаются не аналитики, а сотрудники, которым мы поставляем данные. Аналитики к этому процессу подключаются реже, когда требуется наиболее глубокий анализ с использованием статистических или других, более сложных методов анализа.

Специалиста отличает не столько владение определёнными навыками и инструментами, сколько знание, когда и где их необходимо применять. Как понять, что «вот сейчас я микроскопом гвозди забиваю»? Или это всегда субъективная оценка?

Это приходит с опытом, я не раз встречал специалистов, которые пытались любую задачу решить с помощью Microsoft Excel. Это, безусловно, мощный инструмент для обработки и визуализации данных, но до определённого объёма. Если в вашем наборе данных сотни тысяч строк, то Excel уже будет неэффективен для их обработки.

Чем больше технологий в вашем тулбоксе, тем больше вероятность того, что вы решите поставленную задачу наиболее оптимальным способом. Поэтому тут опять же большим плюсом будет интерес к сфере и изучению новых технологий обработки данных.

Инструменты интернет-аналитики ↑

Перейдём к самим микроскопам. Что из себя представляет инструментальный набор интернет-аналитика?

Если говорить именно об интернет-аналитике, то обязательными будут:

- платформы веб-аналитики: Google Analytics и Яндекс.Метрика, диспетчер тегов Google Tag Manager;

- базовое понимание JavaScript, HTML, CSS и XPath;

- продвинутые навыки работы в процессорах электронных таблиц Google Spreadsheets и Microsoft Excel;

- понимание принципов работы с API-интерфейсами как минимум на уровне, достаточном для разработки технических заданий.

Если разбить все инструменты на сферы применения и обозначить, какие инструменты помогают в решении какого рода задач, можно сформировать следующую таблицу:

| Cфера применения | Инструмент | Решаемая задача |

|---|---|---|

| Счётчики веб-аналитики | Яндекс.Метрика Google Analytics | Стандартизированный сбор данных о поведении пользователей. |

| Диспетчер тегов | Google Tag Manager | Внедрение скриптов для отслеживания действий посетителей сайта без привлечения веб-разработчиков. |

| Языки разметки и фронтенда | HTML CSS XPath JavaScript | Передача данных с сайта в платформы веб-аналитики. |

| Электронные таблицы | Excel Google Таблицы | Обработка и визуализация данных небольшого объёма. Эти инструменты хорошо подходят для решения разовых аналитических задач. |

| Базы данных | Google BigQuery MySQL PostgreSQL | Хранение статической информации (которая редко изменяется задним числом) для долгосрочного использования. |

| Язык запросов | SQL | Обработка данных больших объёмов. |

| Языки программирования | R Python | Анализ и визуализация данных большого объёма. Взаимодействие с API рекламных площадок и прочих сервисов. Автоматизация процесса сбора и очистки данных. Автоматизация рутинных, ручных операций. Проведение статистического анализа данных. Веб-скрапинг (парсинг сайтов). |

| Платформы бизнес-аналитики | Microsoft Power BI Tableau Qlik | Построение модели данных. Интерактивная визуализация данных с разграниченным доступом для совместного использования. |

Хочу отметить, что веб-аналитик должен владеть далеко не всеми приведёнными в таблице инструментами и технологиями. Так, например, языки программирования R и Python относятся к Data Science. Базы данных и SQL также являются отдельным направлением, которое с веб-аналитикой по большому счёту не пересекается. Наконец, BI-платформы решают задачи бизнес-аналитики (Business Intelligence), и интернет-аналитик будет скорее их пользователем, чем разработчиком.

В общем, если в вашей компании есть потребность в решении приведенных в таблице задач, наиболее вероятно, что вам придётся нанимать сразу несколько специалистов, как минимум веб-аналитика, администратора баз данных (DBA) и бизнес-аналитика (BI) или специалиста по данным (Data Scientist). Найти специалиста, обладающего навыками работы сразу со всеми приведёнными выше инструментами, — задача не из лёгких.

Счётчики веб-аналитики располагаются на собственных сайтах, а что делать, если своих данных нет, а исследование провести необходимо?

Зависит это напрямую от того, где эти данные можно получить, наверняка нужную информацию можно получить либо с помощью парсинга сайтов, либо из источников открытых данных вроде Всемирного банка. Такого рода задачи относятся отчасти к области Data Mining, вернее к её разделу по добыче данных. В том же языке R есть для этого довольно обширный функционал, например пакеты rvest и RSelenium. По этой теме есть хорошая книга Дмитрия Харламова «Сбор данных в интернете на языке R». Если вам нужные какие-то данные и где-то эти данные есть, то остаётся лишь подобрать инструмент, с помощью которого вы сможете их получить.

Насколько важен принцип «Мусор на входе — мусор на выходе»? Источники данных — ключевой фактор в интернет-аналитике?

Что касается «мусора на входе», эта ситуация довольно часто встречается, как раз если получать необходимые данные приходится из внешних источников. Тут опять же есть ряд инструментов, которые помогут привести полученный набор данных в пригодный для дальнейшего анализа вид. Если говорить про язык R, то стоит обратить внимание на пакет tidyr.

Для того чтобы не получить «мусор на выходе», перед началом анализа необходимо чётко сформулировать вопросы, на которые в ходе анализа вы планируете получить ответы, иначе никакого результата от его проведения вы, скорее всего, не получите.

Источники данных имеют различные показатели: «пользователь» в Google Analytics и «посетитель» в Яндекс.Метрике — различные сущности. Как вы решаете задачу приведения к общему знаменателю? Или на практике нет потребности в объединении данных из нескольких источников?

Каждый источник данных, включая счётчики веб-аналитики, будет использовать различные показатели. Это касается не только аналитики, попробуйте взвесить один и тот же предмет на разных весах или повесить рядом в одном помещении два термометра. Вы получите разные значения, хотя, скорее всего, данные не будут иметь статистически значимого отличия. О росте объёма трафика на сайте вы узнаете, посмотрев как в отчёты Яндекс.Метрики, так и Google Analytics.

По своему опыту могу сказать, что не стоит использовать для анализа одной области большое количество различных источников. Если вы хотите проанализировать поведение пользователей на сайте, не надо для этого смотреть и в Метрику, и в Analytics. Выберите инструмент, который вам удобен и принцип работы которого вам более понятен. Если вы понимаете, как формируется количество сеансов со всеми нюансами в Google Analytics, но о том, как считаются визиты в Яндекс.Метрике, имеете только общее представление, то используйте Google Analytics. И наоборот, если вы разбираетесь в деталях Метрики, пользуйтесь именно этим инструментом.

Базы данных ↑

Почему не хватает простых таблиц или данных в формате CSV, какая потребность в SQL?

Это как раз ближе к теме о гвоздях и микроскопах. Электронные таблицы действительно удобны для обработки и визуализации данных, но эффективно работать они могут только с небольшими наборами данных, не более пары десятков тысяч строк. Если данных больше, то таблицы займут всю оперативную память и процессор вашего ПК.

К тому же в CSV файлах и электронных таблицах неэффективно хранить и тем более накапливать информацию. Данные в базах хранятся в значительно более компактном виде и занимают меньше места на жестком диске.

Сохранность данных — ещё одна весомая причина: как правило, для базы данных настраивается автоматическое создание дампов данных, и эти дампы хранятся на другом сервере или ПК. С CSV-файлами это сделать сложнее и вряд ли имеет смысл.

Базы данных имеют мощный функционал по разграничению доступа к данным. Кому-то вы можете открыть доступ на чтение только к одной таблице и даже только к отдельным столбцам конкретной таблицы. Для совместной работы, связанной с внесением изменений в данные, при многопользовательском режиме работы в большинстве современных баз данных реализован механизм транзакций. Причём для отдельных операций по изменению данных можно настраивать различные режимы изолированности транзакций.

Если вам необходимо единоразово проанализировать небольшой набор данных для личных целей или поделиться только конечной визуализацией этих данных, то, пожалуйста, используйте электронные таблицы. Если речь идёт о долгосрочном хранении больших объёмов данных, к которым необходимо обеспечить разноуровневый доступ большому количеству пользователей, а также быть уверенным в том, что с данными ничего не случится, то в любом случае вам понадобятся базы данных. На сегодняшний день существует довольно много хороших бесплатных решений, как серверных, например MariaDB (потомок MySQL) и PostgreSQL, так и локальных — SQLite.

Python vs R ↑

Когда разговор заходит о программировании для анализа данных, нередки споры о выборе языка. Вы сами какой предпочитаете и почему?

Так получилось, что первым я выучил R и практически сразу начал с его помощью решать большинство своих боевых задач. В первую очередь я написал скрипт, который собирал статистику из рекламных аккаунтов Google AdWords в базу данных. Это не говорит о том, что R лучше, чем Python. Просто три года назад мне на Хабре попался анонс курса Анатолия Карпова «Основы статистики» от Санкт-Петербургского института биоинформатики. Я его прошел, а через месяц мне на почту пришло уведомление, что стартует продолжение в виде курса «Анализ данных в R». Ещё спустя какое-то время появились курсы «Анализ данных в R. Часть 2» и «Основы программирования на R», автором которого является Антон Антонов. Так я и выучил R.

R воспринимают как язык математиков и академических исследований. В каких случаях, по вашему мнению, к нему стоит обращаться?

На самом деле первое время, в период с 1993 по 2005 год, R использовали исключительно для проведения академических исследований. Он и сейчас остаётся любимым инструментом статистиков и математиков, но в последние годы этот язык набирает популярность и в других отраслях, в частности в маркетинге.

Возможности R довольно обширны, вы можете использовать его, вообще не имея знаний в статистике и высшей математике. Например, в задачах по автоматизации сбора и очистки данных, для их визуализации. С помощью технологии RMarkdown можно оформлять статьи, приведя их в пригодный для публикации вид, сохранив в pdf- или html-формат. Пакет bookdown позволяет разрабатывать целые сайты, а с помощью telegram.bot вы можете создавать ботов для Telegram.

R очень динамично развивается и имеет большое сообщество пользователей. Они всё время расширяют базовые возможности языка, создавая новые пакеты функций. Поэтому область его применения ограничивается лишь вашими задачами и фантазией.

Вы и сами разработали несколько пакетов для R, расскажите о них подробнее.

Функции, из которых состоят разработанные мной пакеты, изначально были написаны для решения внутренних задач по сбору данных из различных рекламных источников и платформ веб-аналитики: Яндекс.Директ и Яндекс.Метрика (ryandexdirect), MyTarget (rmytarget), Вконтакте (rvkstat) и Mixpanel (rmixpanel).

Каждый из перечисленных выше пакетов представляет из себя R-клиента для работы с API одноименных сервисов. Если вы хотите, например, получить статистику по вашим рекламным кампаниям в Яндекс.Директ, каким-то образом обработать полученные данные или просто сохранить их в свою базу, эти пакеты избавят вас от необходимости:

- разбираться с устройством API-интерфейсов и http-запросов;

- знакомиться с довольно большими объёмами документации по работе с API каждого отдельного сервиса;

- создания и подтверждения со стороны Яндекса своего приложения для доступа к API Яндекс.Директ и Яндекс.Метрики. Процесс подтверждения приложения достаточно непростой и требует детального описания того, какой функционал ваше приложение будет реализовывать, какие методы API будет использовать, как вы будете вести логирование ошибок при обращении к API и как работать с его ограничениями.

По сути, использование разработанных мной пакетов даёт возможность маркетологу, который совершенно не имеет навыков программирования, взаимодействовать с API-интерфейсами рекламных площадок. Для старта достаточно будет скачать и установить на свой ПК наиболее актуальную версию языка R, среду разработки RStudio и ознакомиться с небольшой документацией по использованию нужного вам пакета на GitHub.

Изначально все пакеты были написаны для решения внутренних задач Netpeak. После публикации в корпоративном блоге нескольких статей, посвященных работе с ними, идею их использования подхватили другие агентства и компании:

- Антон Леонтьев из eLama рассказал о том, «как загрузить статистику из рекламных систем в Google BigQuery»,

- Дмитрий Малых из pm-partner написал статью «Подключение Power BI к Yandex.Metrika»,

- Андрей Москалец поделился своим скриптом в статье «Облако минус слов для Яндекс.Директ»,

- совсем недавно Дмитрий Осиюк из компании ЛУН.ua рассказал, «как определить мошенничество CPA-сетей с помощью Logs API Yandex.Metrika и R».

Все эти люди на самом деле не программисты, а маркетологи и аналитики. Пакеты дают им возможность без углубления в тонкости программирования решать свои повседневные задачи средствами, расширяющими базовые возможности языка R.

Следить за развитием моих пакетов и их возможностей можно в разделе новостей на их основном портале, ВКонтакте в группе Data Club, в рубрике языка R в моём личном блоге, а также подписавшись на telegram-канал R4marketing.

А что насчёт Python? За ним закрепилась слава одного из простых языков программирования, верно ли это, и в каких случаях лучше отдать предпочтение ему, а не R?

Когда я начал изучать Python и прошёл первый курс, он произвел очень приятное впечатление. Простой, легко читаемый и запоминающийся синтаксис является одним из привлекательных качеств этого языка.

В боевых условиях пока опробовать возможности Python я не успел. Аккумулируя информацию из различных источников, могу высказать мнение, что Python быстрее, чем R, и он работает с любыми объёмами данных. В то время как R в своей базовой комплектации способен обработать данные, которые помещаются в оперативную память вашего ПК.

Что касается статистики и визуализации данных, Python значительно проигрывает в количестве готовых решений и их гибкости. Я уже отметил, что R является любимым инструментов статистиков, поэтому все новые разработки и методы в этой области сначала появляются в виде пакетов для R. Лишь через какое-то время реализуются уже не статистиками, а программистами в Python. Поэтому в плане качества кода статистические функции в Python написаны красивее и оптимальнее, а вот сами алгоритмы статистических вычислений реализованы не так качественно, как в R.

Подытожив, можно сказать, что большинство задач по автоматизации различных процессов можно решить как в R, так и в Python, но для статистики и визуализации рекомендую всё же использовать R, для разработки веб-приложений — Python.

Визуализация данных ↑

Какую вы роль отводите визуализации результатов исследований?

Основная функция визуализации данных — облегчить восприятие информации, то есть вместо громоздких таблиц выразить основную идею в виде понятного изображения. На самом деле визуализация данных — это целое искусство. Каждый аналитик должен уделять ей достаточно внимания.

Для того чтобы вам было что визуализировать, сначала необходимо найти в данных какие-то ответы и полезную информацию. То, в каком виде вы эту информацию будете подавать, — уже второй вопрос, поэтому без погружения в аналитику ничего не получится.

В руках неопытного пользователя визуализация может сыграть негативную роль и скорее запутать читателя, увести далеко от той идеи, которую хотел с помощью диаграммы сообщить автор.

Я рекомендую каждому начинающему аналитику к прочтению замечательную книгу Джина Желязны «Говори на языке диаграмм». Как минимум она поможет избежать наиболее грубых ошибок в выборе типа диаграммы.

Для более опытных пользователей, которые хотят научиться строить всевозможные графики средствами языка R, советую присмотреться к книге автора блога r-analytics.blogspot.ru, Сергея Мастицкого, «Визуализация данных с помощью ggplot2». Она посвящена работе с одним из наиболее популярных пакетов для R, созданного как раз для построения диаграмм.

Автоматизация интернет-аналитики ↑

Насколько отдельные этапы аналитики поддаются автоматизации, заканчивается ли на ней работа аналитика?

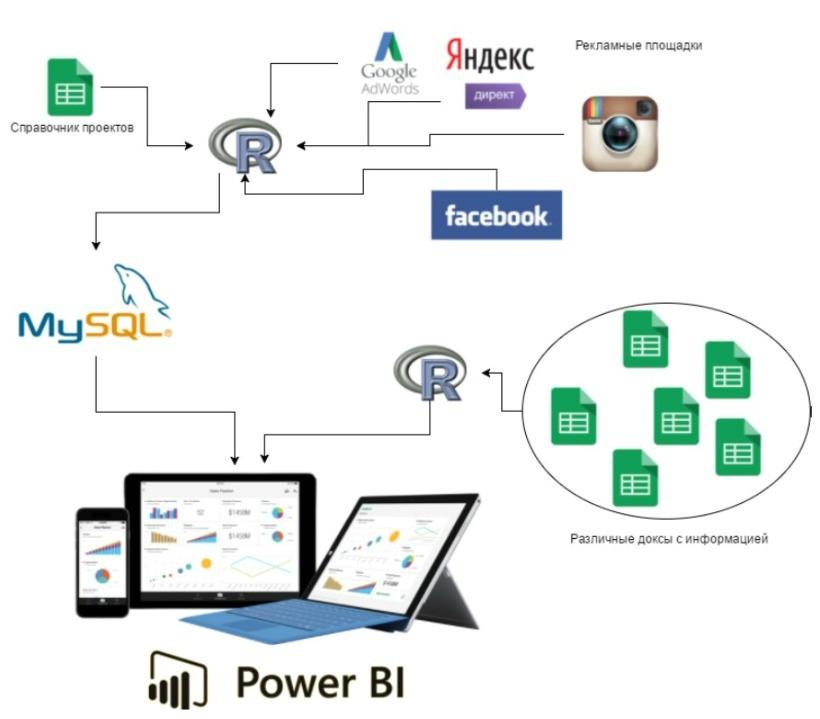

Как раз в докладе «Как разобраться со своими данными, если ты не аналитик» я привёл несколько примеров того, как мы в Netpeak автоматизировали большинство процессов, направленных на работу с данными.

Пока в компании работает несколько десятков человек, большой проблемы при ручном выполнении всех операций не будет. Если отдел аналитики получает запросы от сотен сотрудников, штат аналитиков будет постоянно расти, а вместе с ним и фонд оплаты труда, поэтому лучше изначально максимально автоматизировать все этапы аналитики.

Начинается всё со сбора данных. Большинство сервисов, которые являются источниками данных для интернет-аналитика, имеют API. Автоматизировать их извлечение и передачу можно с помощью любого языка программирования (R, Python или PHP). Автоматизировав процесс сбора данных, мы исключаем ошибки, вызванные человеческим фактором.

Контроль качества собранных данных и весь ETL (extract, transform, load) процесс автоматизируется теми же средствами. Вы определяете ряд правил, которые необходимо проверить при сборе данных, и отлавливаете сбои в ходе работы автоматизации.

Автоматизировать визуализацию и разграничить доступ к данным помогают BI-платформы. Отчасти они же могут обращаться напрямую к большинству источников данных, так как имеют в коробке большой набор различных коннекторов.

Алгоритмы машинного обучения помогают автоматизировать процесс анализа и получения результатов на основе собранных вами данных без привлечения человека к этому. Хорошим примером их применения являются системы рекомендации товаров в интернет-магазинах. Рекомендательные системы, исходя из каких-то общих паттернов поведения, определяют пользователей в различные кластеры по интересам, а затем подбирают для вас товары, которые, наиболее вероятно, будут вам интересны.

Подробнее о том, как мы автоматизировали некоторые из этих процессов, можно узнать из статей: «Как мы внедрили BI-аналитику в отделе контекстной рекламы», «Как сэкономить время специалиста при работе с крупным проектом — на примере OLX», «Как мы сделали аналитический инструмент для блога Netpeak».

Не окажется ли в ближайшем будущем так, что будет достаточно настроить интеграцию между источниками данных и автоматизированной средой для анализа? Стоит ли тратить время на эти навыки?

Данных, как и их источников, с каждым днём становится всё больше, а методы их анализа сложнее. Большинство решений автоматизации являются индивидуальными. Конечно, появляются различные сервисы, которые помогают автоматизировать часть операций по сведению данных из различных источников, но я очень сомневаюсь, что появится какой-то сервис, который поможет вам решить все проблемы нажатием одной кнопки. Другой вопрос в том, что и знания теряют актуальность, например 8–10 лет назад знание функции ВПР в Microsoft Excel было для многих чем-то из области фантастики, сейчас уже вряд ли вы ей кого-то удивите.

С чего начать изучение аналитики ↑

Какой совет дадите тем, кто решит стать интернет-аналитиком: что изучать, в каком объёме и в какой последовательности?

Любому аналитику, неважно, на чём именно он специализируется, — интернет-, бизнес-аналитика или ещё что-то, — необходимо уметь правильно визуализировать результаты своего анализа, иметь продвинутые навыки работы в электронных таблицах. Далее уже идёт разветвление: для веб-аналитика, конечно же, необходимо разобраться с наиболее популярными системами веб-аналитики Google Analytics и Яндекс.Метрикой, плюс, помимо инструментов, разобраться со всеми показателями, которые используются при анализе поведения посетителей сайта.

Сегодня у вас есть возможность получить профессию будущего. Спрос на аналитиков растёт быстрее, чем их количество. Эта тенденция в ближайшее время не изменится, скорее всего, потребность в специальности будет только расти. Сегодня на рынке недостаточно аналитиков, вызвано это во многом тем, что добывать знания приходится самостоятельно, поэтому эта ниша на рынке труда пока что практически свободна. Можно занять в ней своё место.

С чего порекомендуете начать? С изучения теории интернет-маркетинга, баз данных, языков программирования или присоединиться к существующему проекту и уже на практике с нуля разбираться во всём?

Обучение — это трудоёмкий и длительный процесс. Лучше сразу выработать привычку выделять хотя бы несколько часов в неделю на прохождение онлайн-курсов или чтение профильной литературы. Ещё один важный момент: все знания, которые вы получаете в процессе обучения, необходимо применять в решении повседневных задач. Иначе всё очень быстро забывается, поэтому в первую очередь беритесь за изучение тех инструментов, которые сразу сможете использовать на практике, которые избавят вас от рутины.

Идеально, если получится присоединиться к существующему проекту и у вас будет куратор, который постепенно всему вас научит. Если же не получается найти такой вариант, то начинать стоит с электронных таблиц. Этот инструмент используется всеми и на первых порах поможет частично автоматизировать многие ручные операции. Далее изучайте основы веб-аналитики и продвижения интернет-проектов, после чего стоит пробежаться по основам языков разметки HTML, CSS и, наконец, JavaScript.

Затем смотрите по задачам, далеко не всем веб-аналитикам приходится сталкиваться с базами данных и программированием. В принципе, вряд ли от вас на данной позиции эти знания кто-то будет требовать, но если хотите развиваться, то следующим шагом смотрите в сторону баз данных и SQL. Без этого в программировании будет трудно. В конце концов, если вы уже овладели SQL, то выбирайте, что вам больше нравится — R или Python.

Какие требования предъявляются интернет-аналитику? Кого вы бы взяли на работу?

Интерес к сфере — это, пожалуй, касается не только аналитики, занимайтесь тем, что вам нравится и что вам интересно, изучение конкретных инструментов — дело времени. К тому же все инструменты развиваются, и появляются различные новые технологии обработки данных. Знания, которые были в цене 5–10 лет назад, сейчас уже никому не нужны. В первую очередь работа должна стать вашим хобби, тогда вы достигните высоких профессиональных результатов.

А кому не советуете идти в интернет-аналитику?

Скорее всего, если вы в школе спали на уроках математики и, наоборот, с удовольствием и большим интересом посещали историю и литературу, думаю, аналитика вас надолго не заинтересует. Не стоит идти в эту профессию только потому, что она сейчас популярна. Аналитика — сугубо техническая наука, и гуманитариям в ней будет скучно.

Алексей, благодарим вас за беседу!